立命館大学創発システム研究室の准教授ガルシア・グスタボです。2021年3月末に閉室となったロボティクス研究室(教授:小笠原司副学長)のOBで元スタッフでもあります。数年前からは「NAIST-RITS-Panasonic」のキャプテンも務めています。このチームは、ロボットで現実世界の問題を解決したいという情熱ある研究者・技術者たちで結成され、以下の国際ロボット競技会「Airbus Shopfloor Challenge 2016、Amazon Robotics Challenge 2017、WRS Future Convenience Store Challenge 2018-2022」に積極的に参加しています。

I am Gustavo Garcia, Associate Professor at the Emergent Systems Lab of Ritsumeikan University and an alumnus and former staff of the ci-devant Robotics Lab (NAIST), led by the now retired Prof. Ogasawara. Since a few years back, I am also the captain of team NAIST-RITS-Panasonic, a collective of researchers and engineers driven by the passion for solving real-world problems with robots, and an avid participant in international robotics competitions (Airbus Shopfloor Challenge 2016, Amazon Robotics Challenge 2017, WRS Future Convenience Store Challenge 2018-2022).

今回は、私のチームが提案するロボットを活用した未来のコンビニエンスストアを紹介します。未来と言ってもそう遠くないことを願っていますが、私たちが構想しているコンビニエンスストアではお察し通り、ロボットの店員がいます。そこでは、人間とロボットが自然で、直感的で、円滑なやりとりをしています。ロボットは店舗スタッフの面倒な仕事を助け、客はロボットが作業している間でも自由に欲しい商品を選ぶことができます。これらの技術は、2021年に開催された「Future Convenience Store Challenge(FCSC)2020」で評価され、「商品陳列・廃棄タスク」と「トイレ清掃タスク」で1位を獲得し、総合優勝を飾りました。また、2022年には国際会議IROS2022で「Future Convenience Store Challenge 競技(WRS FCSC Trial Competition@IROS2022)」が開催され、「陳列・廃棄タスク」部門での1位を獲得し、2019 年、2020(2021)年に続き連覇を果たしました。

This time, I would like to introduce the robotics technologies that my team has proposed for building the convenience stores of the (hopefully not that far) future, a future with –yes, you guessed well– some robotic employees. In the envisioned convenience stores, humans and robots interact naturally, intuitively, and harmoniously. Robots help staff with tedious –even unpleasant– tasks, while customers can freely pick the desired products even during the robot operation. We benchmarked these technologies at the Future Convenience Store Challenge (FCSC) 2020 (held in 2021), where we obtained the two 1st places in the Restock/Disposal task and the Restroom Cleaning task, as well as the Overall Winner Prize. In 2022, the Future Convenience Store Challenge (WRS FCSC Trial Competition@IROS2022) was held at the international conference IROS 2022, and we won the first place in the Restock/Disposal task. This is the third time our team has won in this task, following first place in 2019 and 2020 (2021).

チーム紹介/The team

「NAIST-RITS-Panasonic」は、NAIST、立命館大学、パナソニックホールディングス株式会社Robotics Hubのメンバーで構成されています。これまで6代にわたり、多くの研究者や学生、エンジニアが自身のスキルを活かし、熱い思いをもって、数多くのロボット製作に貢献してきました。私たちが製作したロボットは様々な国際ロボット競技会で評価されています。

The NAIST-RITS-Panasonic is formed by NAIST, Ritsumeikan University, and the Robotics Hub of Panasonic Corporation. During the six generations of the team, numerous researchers, students, and engineers have contributed with their talent, dedication, and passion to the creation of numerous robots benchmarked at various international robotics competitions.

チャレンジの様子/The challenge

2017年、経済産業省と国立研究開発法人 新エネルギー・産業技術総合開発機構(NEDO)は、ロボット技術に関する国際イベントWorld Robot Summit(WRS)の日本開催を決定しました。WRSは、ロボット活用の現在と未来の姿を発信する展示会(WRE)と世界中から集結したチームがロボット技術やアイデアを競う競技会(以下WRC)とで構成されています。WRCのサービス部門では、高齢化で労働力が損なわれているような店舗にイノベーションを起こすきっかけとして、「Future Convenience Store Challenge(以下FCSC)」がスタートしました。

競技の課題は以下の3つのタスクです。

In 2017, METI and NEDO decided to organize an international event about robotic technology called World Robot Summit, with an exhibition track (WRE) and a competition track (WRC), in Japan. Within WRC, in the Service category, the Future Convenience Store Challenge (FCSC) arose as an opportunity to foster innovation and channel it to the ubiquitous stores, whose workforce is compromised by societal aging. The challenge consisted of the following three tasks:

- 陳列タスク/Restock and Disposal Task

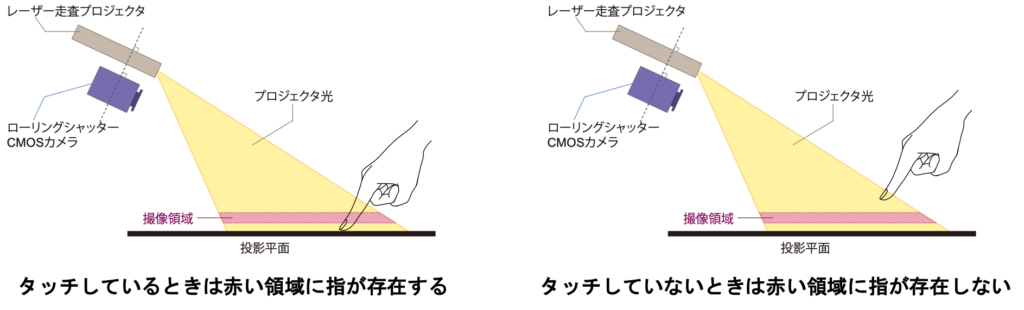

“心は目に従う”といわれます。コンビニエンスストアでは、商品を美しく並べることが、店内を見て回る客へのアピールになります。その一方で、常に鮮度の高い商品を陳列することがリピーターの獲得につながります。この「美しい陳列」と「鮮度管理」は、コンビニエンスストアのスタッフが抱える課題です。というのも、店内を見て回っていた客が意図せずに商品を棚に戻して入れ替えする可能性があったり、賞味期限切れの商品を棚から取り除く必要があったりするからです。店内ではこういったことが日々起きています。

They say that “the heart follows the eyes.” In convenience stores, products arranged in an esthetic fashion are more appealing to browsing customers. On the other hand, finding fresh products always translates into recurring customers. These are two challenges faced by convenience stores’ staff because browsing customers can unintendedly leave put-back products disarranged, and expired products must be removed from the shelves… and this happens every single day.

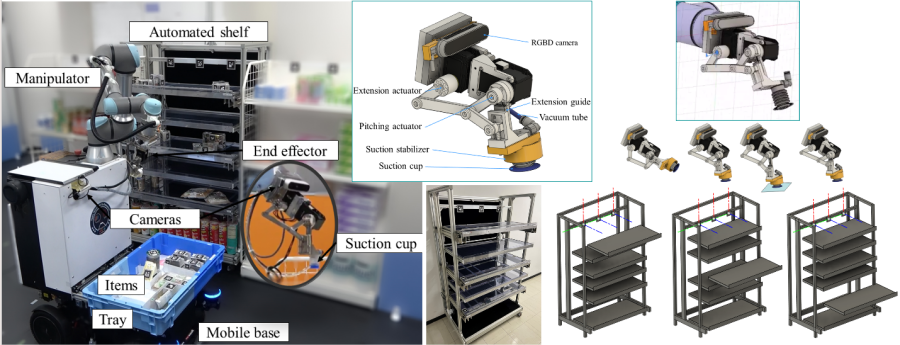

そこで私たちは、棚にある商品を自律的に整頓し、賞味期限切れの商品を取り除き、新しい商品を補充するロボットシステムを構築しました。ロボットは、アームの付いた可動式のベースと、特注のロボットハンドで構成されています。ロボットはカメラで商品を見て、どのような行動を取るべきかを判断し、起こりうるエラーと復旧策を常に検討します。客がロボットに近づくと、ロボットは動作を停止して後退し、客に商品を選択できるようにします。そして客が立ち去ると、ロボットは人間のスタッフと同様に作業を続けます。

We have built robotic systems to autonomously straighten products on shelves, remove expired products, and restock the shelves with new products. The robot consists of a mobile base with an arm and a custom-made robot hand. The robot uses a camera to look at the products and decide what action to take, always considering the possible errors and the strategies to recover from them. When a customer is close to the robot, the robot halts the operation and retreats to allow the customer to pick the products. Once the customer leaves, the robot continues the task, as a human staff would do.

- トイレ掃除タスク/Restroom Cleaning Task

トイレ掃除が好きな人はいるでしょうか?もしかしたらいるかもしれませんが、好きだという人以外は、コンビニのレジ仕事の方が良いかもしれません。とはいえ、掃除は日常的に必要な仕事です。

Is there anyone who loves to clean restrooms? Maybe, but for the rest of us, we rather are at the cashier in a convenience store. However, cleaning is a needed, everyday task.

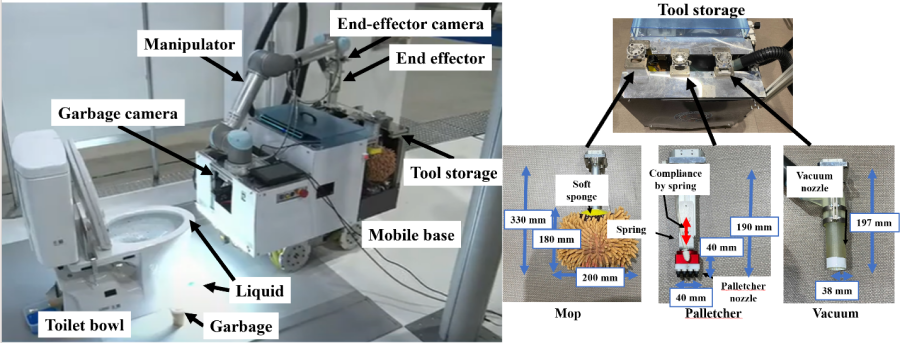

そこで、液体を拭き取り、紙片を吸引し、空のトイレットペーパーの芯や使い捨てのコーヒーカップを自律的に掃除するロボットを作りました。液体が入っている場合は、中の液体をこぼすことなく作業ができます。このロボットは、アーム付きの移動ベースと、特注の3つのロボットハンドで構成されています。ロボットはディープラーニングとカメラの画像からゴミの種類を検出し、最適な道具を選択します。客がトイレを利用したい場合、ロボットは道具を残すことなくトイレから離れます。そして客が立ち去ると、ロボットは清掃を継続します。

We have built a robot that can autonomously clean a restroom by wiping liquids, vacuuming pieces of paper, and removing empty paper rolls and even disposable coffee cups (without dripping the liquid inside!). The robot consists of a mobile base with an arm and three custom-made robot hands. The robot detects the type of garbage using deep learning and images from a camera and selects the most suitable tool. When a customer wants to use the facilities, the robot retreats from the restroom without leaving any tools behind. Once the customer leaves, the robot continues cleaning.

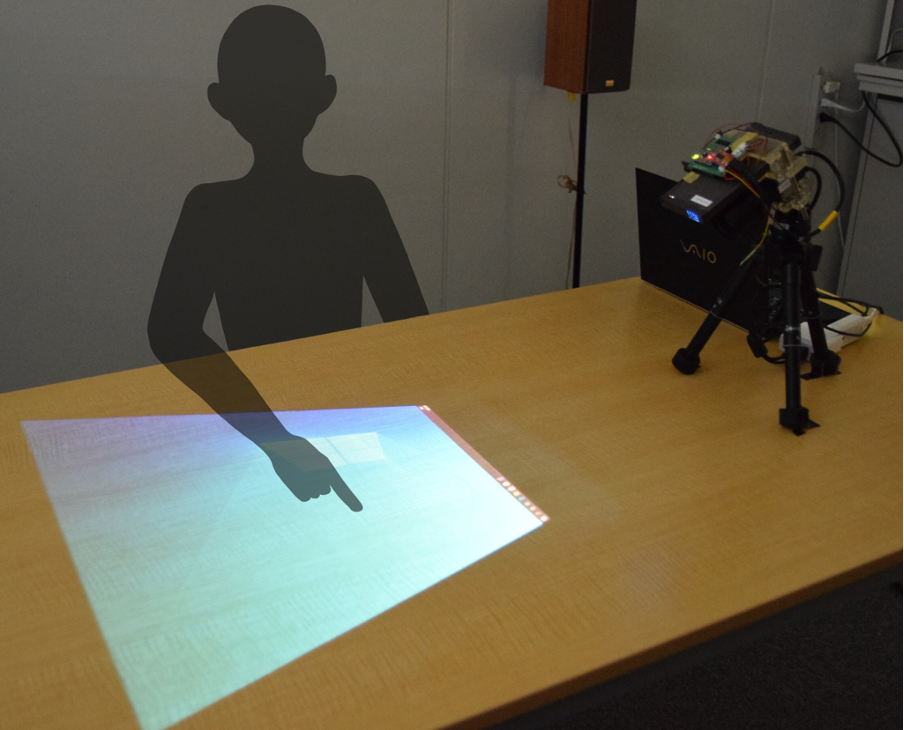

- 接客タスク/Customer Interaction Task

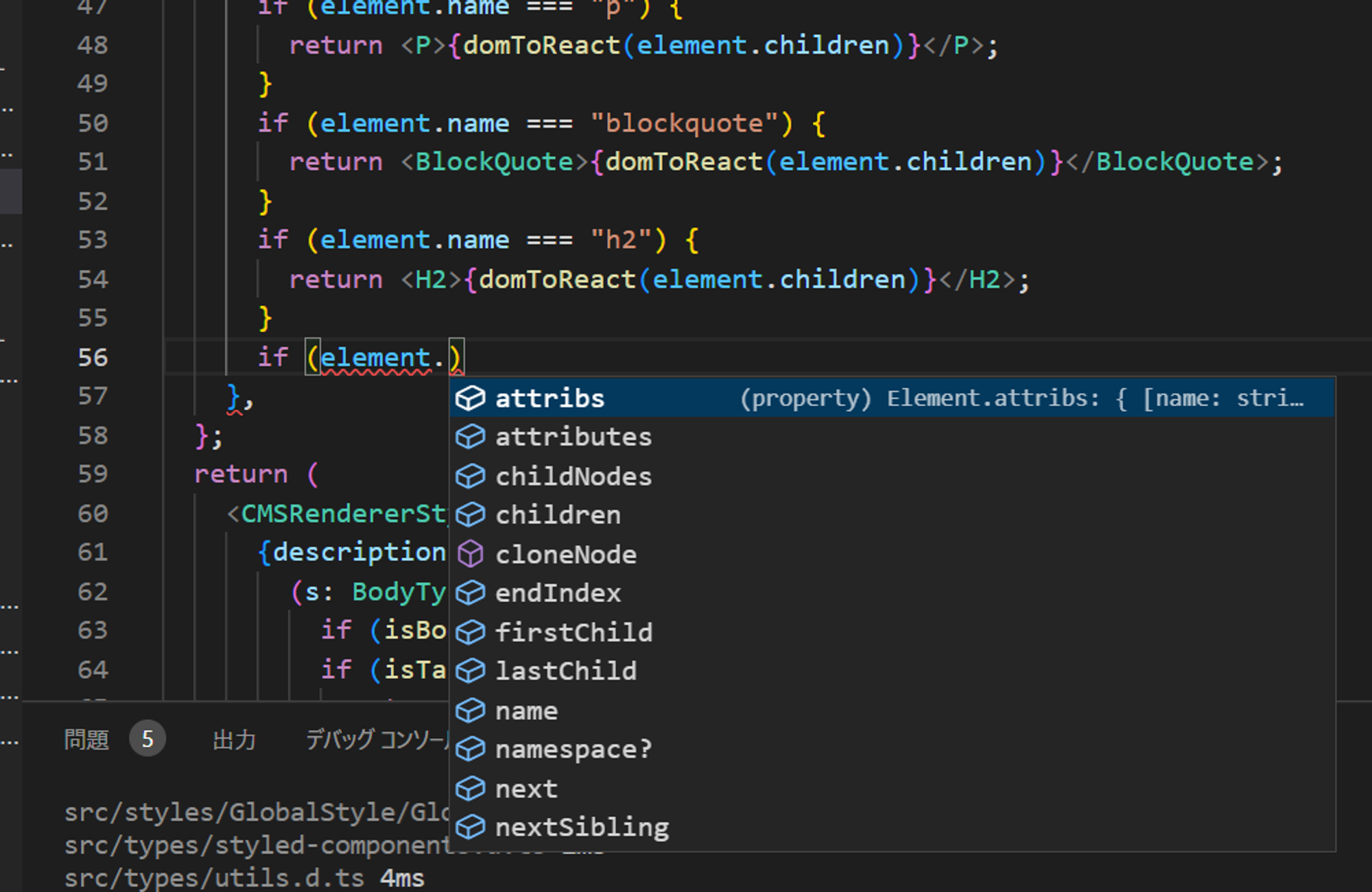

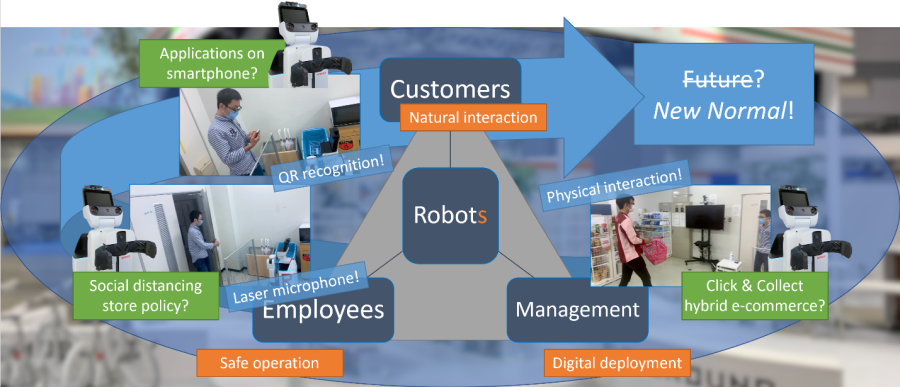

ニューノーマルが叫ばれる昨今、ロボットによる遠隔操作への期待が高まっています。スタッフと客、客と商品を非接触で橋渡しすることで、ニューノーマルという制約の下でもロボットは重要な役割を果たすことができるのです。 私たちは、店内を案内したり、最新の商品を紹介したり、自然な言葉で対話できるロボットを提案しています。また、アプリで選んだ商品をロボットが遠隔で取り、入口で客が受け取れるようにしました。そして、伝染病対策として広く利用されているアクリル壁越しでも、レーザーマイクを通してスタッフが客の声を聞き取れるようにしました。複合現実感のあるゴーグルを使用することで、スタッフはロボットの状態を観察でき、直感的に素早く情報を共有することができます。さらに、ドラッグ&ドロップ操作により、プログラミングやロボットの知識がなくても、ロボットの動作をつくったり、カスタマイズしたりできます。こうして究極のコンビニエンスストア体験が実現します。

As the new normal governs in recent years, the potential of robotic distancing seems promising. By bridging staff and customers in a contactless manner, as well as customers and products, robots can play a key role for happiness even under the new-normal restrictions.

We have proposed robots that can usher customers around the store, show them the latest products, and interact with natural language. We have enabled customers to have robots pick up the products selected through an app remotely and receive them at the entrance. Through laser microphones, staff can hear customers behind an acrylic wall, a widely used contagion countermeasure. With mixed reality googles, the staff can monitor the robot’s status and quickly, intuitively share information. Finally, with a drag-and-drop interface, staff without any programming or robotics knowledge can create and customize the robot’s behavior to realize the ultimate convenience store experience.

今後の展開/Future work

私たちのチームはFCSCでロボットをベンチマークし、その過程で複数の優勝を獲得しましたが、自らのビジョンを実現するための追求は、まだまだ続いています。今後は、未知の環境、未知の商品であっても、パッケージやフィデューシャルマーカー(物の位置や向き・大きさを測定するためのマーカー)のない商品を操作し、自然な形で客と対話し、自律的にタスクを計画するプロジェクトを進めていく予定です。

The team has benchmarked the robots at the FCSC, winning multiple first places in the process, but our pursuit of realizing our vision continues. Next, we will further our research project to manipulate products without any packages and fiducial markers (to identify the location, direction, and scale of packages), interact with customers in a natural way, and plan the task autonomously, even in unknown environments and with unknown products.

AIという光が差し込むとともに、スマートでインタラクティブなロボットが活躍するコンビニエンスストアの未来はかつてないほど明るくなっています。

With the luminescence of AI, the future of convenience stores with smart and interactive robots working for happiness has never looked brighter.

著者紹介/About the author

Gustavo Garcia

2013年に奈良先端科学技術大学院大学(NAIST)にて博士前期課程を修了。2016年に同大学にて博士後期課程を修了。博士(工学)。現在、立命館大学創発システム研究室の准教授、NAISTヒューマンロボティクス研究室の客員准教授、パナソニックホールディングス株式会社Robotics Hubのロボティクスコンペティション研究の顧問を務める。大学や企業で研究に従事するかたわら、数多くの研究プロジェクトや国際的なロボット競技会でチームの指揮をとる。専門は、人間にとって安全で効率的なロボット制御、人間とロボットのインタラクション、モバイルマニピュレーション、タスクプランニングなど。

Gustavo Garcia received his MEng and Ph.D. degrees from the Nara Institute of Science and Technology (NAIST), Japan, in 2013 and 2016, respectively. He is currently an Associate Professor in the Emergent Systems Laboratory at Ritsumeikan University and a Research Advisor for Robotics Competitions at the Robotics Hub of Panasonic Corporation. He leads numerous research projects and teams in international robotics competitions. His interests include human-safe and efficient robot control, human-robot interaction, mobile manipulation, and task planning.