こんにちは、自然言語処理研究室助教の能地です。

自然言語処理というのは、コンピュータの上で言語を扱う研究全般を指します。分かりやすい研究分野だと、ある言語の文章を別の言語の文章に変換する機械翻訳などが該当します。私はこの分野の研究を始めて5年ぐらいですが、今日は私がこれまで取り組んできた、自然言語処理の中でも少し変わった切り口の研究を紹介してその面白さを伝えられたらなと思っています。

自然言語処理の大きな目標は、ことばの意味を理解し、人間のように使用できるコンピュータを構築することです。このためにはなぜ人間がことばを理解し、発することができるのか、その仕組みを明らかにしないといけません。つまり、言語の性質そのものに関する理解を深めることが、より高度な自然言語処理のシステムのために必要であるということです。この考えに基づき、すぐに特定の応用に結びつくわけではないけれども、コンピュータを使って言語に潜む何らかの性質を明らかにしようとする研究が存在します。

私の博士論文の研究も、このような考えに基づいたものです。私が博士論文で着目したテーマは、世界の言語の多様性と普遍性です。これは言語の非常に面白いところだと思うのですが、世界中の人々は地域ごとに全く異なることばを使って生活をしています。例えば英語と日本語を比べると文法も語彙も全く異なっていて、これが私達日本人が英語の習得に苦労する理由ですよね。しかし、全ての言語には一つの共通の性質があります。それはどの言語も人間によって話されるという事実です。当たり前すぎると思うかもしれませんが、これは考えてみると面白いことではないでしょうか。つまり、言語はそれぞれ非常に多様であるにも関わらず、どんな言語にも、それによってコミュニケーションが可能であるという性質があるのです。もう少し考えると、言語はコミュニケーションの道具なのですから、人間同士のコミュニケーションを阻害するような性質は持ちにくいのではないかと予想できます。ここから浮かび上がってくるのが、あらゆる言語の背後には何か共通の普遍的な性質が存在するのではないか、という考えです。そして、このような性質のうち、特に文法レベルの普遍性に着目し検証を行ったのが、私の研究です。

次の文を読んでみてください。

書記が代議士が首相がうたた寝したと抗議したと報告した。

これは文法的には正しい日本語ですが、非常に読みづらいと感じたと思います。私の研究をざっくりというと、どんな言語にもこれと同じ種類の構造を持った文はほとんど出現しない、ということを定量的に評価した研究といえます。さて、この文はなぜ難しいのでしょうか。これは言語学で中央埋め込み文として知られる種類の文になっています。まず、文中の「首相がうたた寝した」は一つの文として成り立ちます。これがまた、「代議士が首相がうたた寝したと抗議した」という文の中に埋め込まれています。最後に、これ自体が文全体の内部に埋め込まれています。今回研究で明らかにしたのは、このように文が二段(以上)中央に埋め込まれている構造が、多数の言語に渡ってほとんど出現しないという事実です。

中央埋め込み文の難しさ自体は現代の言語学が始まったおよそ50年前から知られていたのですが、研究対象は英語や日本語などいくつかの言語に限られていて、これが言語によらず一貫して避けられる構造であるということを大規模にかつ定量的に評価した研究はありませんでした。これが可能になった背景には、自然言語処理における多言語に渡る構文データの蓄積が挙げられます。

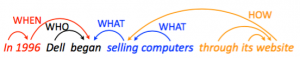

自然言語処理で構文解析として知られる問題があるのですが、これは図のような、文の単語間の関係を係り受けの矢印で表現した構造を予測する問題です。例えば図で Dell -> began という矢印がありますが、これは Dell が began に係っていることを表しています。なぜこのような構造が重要かというと、この構造から文の意味の計算を行うことができるからです。正しい文の構造を予想することで、各係り関係から誰が (WHO) いつ (WHEN) 何を (WHAT) どうした、という情報を捉えることができるようになります。

自然言語処理で構文解析として知られる問題があるのですが、これは図のような、文の単語間の関係を係り受けの矢印で表現した構造を予測する問題です。例えば図で Dell -> began という矢印がありますが、これは Dell が began に係っていることを表しています。なぜこのような構造が重要かというと、この構造から文の意味の計算を行うことができるからです。正しい文の構造を予想することで、各係り関係から誰が (WHO) いつ (WHEN) 何を (WHAT) どうした、という情報を捉えることができるようになります。

近年の アプローチでは構文解析は教師あり機械学習の問題として扱われることが多いのですが、このためには、文とそれに対する正しい構文のペアを大量に用意することが必要となります。この目的のため、近年様々な言語に対し、大量の文に構文情報を付与したツリーバンクと呼ばれるデータが整備させてきました。この研究では、このデータの蓄積に着目しました。具体的にいうと、文に対する係り受け構造が与えらたら、その文にどれほどの中央埋め込み構造が存在するかを測ることが可能です。このことに着目し、様々な、およそ30言語に渡るツリーバンクの上でどれだけ中央埋め込みが存在するかを調べ、言語普遍性の検証を行いました。

アプローチでは構文解析は教師あり機械学習の問題として扱われることが多いのですが、このためには、文とそれに対する正しい構文のペアを大量に用意することが必要となります。この目的のため、近年様々な言語に対し、大量の文に構文情報を付与したツリーバンクと呼ばれるデータが整備させてきました。この研究では、このデータの蓄積に着目しました。具体的にいうと、文に対する係り受け構造が与えらたら、その文にどれほどの中央埋め込み構造が存在するかを測ることが可能です。このことに着目し、様々な、およそ30言語に渡るツリーバンクの上でどれだけ中央埋め込みが存在するかを調べ、言語普遍性の検証を行いました。

また、博士論文ではこの分析を基にして、このように観察された文法上の普遍性が、実際の言語処理の応用に役立つかについても検証を行いました。ここで得られた、言語には深い中央埋め込みが見られないという観察は、言語の文法に対するある種の制約、もしくは事前知識として用いることができます。このことを検証するため、教師なし構文解析と呼ばれる問題で制約の効果を検証し、性能が向上することを確認しました。教師なし構文解析は自然言語処理の中でも非常に難しい問題として知られているもので、明示的な構文構造の正解を機械学習の訓練データとして与えない状況での構文解析の問題です。博士論文では、この問題に対し中央埋め込みを避けるという構造上の制約をどのように組み込むか、そしてその制約が様々な言語において効果的に働くことを確認しました。また、この研究の成果は最近国際会議のEMNLPに採択され、発表する予定になっています。

最近の話題

今回紹介したような研究は、言語に存在する規則性を計算機を使って明らかにする研究といえます。これは、現在の自然言語処理の中では決して花形の研究とは言えないのですが、最近これに関連した少し興味深いことがあったので、そのことを報告します。

先月自然言語処理の最大の国際会議である ACL がベルリンで開催され、参加してきました。そのベストペーパー、つまり今年最も重要と認められた論文に関する話題です。論文のタイトルは「Finding Non-Arbitrary Form-Meaning Systematicity Using String-Metric Learning for Kernel Regression」でした。

ソシュールを知っている人は、シニフィアンとシニフィエという言葉を聞いたことがあるでしょう。シニフィアンは単語の音、シニフィエは単語の意味を表し、これらの間には恣意的な結びつきしかない、というのがソシュールの主張です。さて、本論文のタイトルは “Finding Non-Arbittary Form-Meaning” とあるので、これはソシュールの主張とは逆に、意味と音の間には無視できない相関があるのではないかと仮定し、どれほどそのような相関が存在するかを大規模データをもとに定量的に評価した研究といえます。具体的な例では、英語で “gl” から始まる語の多くは視覚に関連することが知られています (glint, glaze など)。論文では、このような結びつきを検出するアルゴリズムを設計し、それを基に様々な検証を行っています。

ACL での他の研究の多くが、複雑なニューラルネットなど新しい機械学習のアルゴリズムに焦点を当てているのに対して、このような言語学寄りの研究がベストペーパーに選ばれたのは非常に印象的でした。個人的にはこのような研究がもっと増えて評価されていけば良いなと思っているところです。

今後について

特に国内の研究者で、今回紹介したような切り口で研究を行っている研究者は非常に少ないため、今後もこういった研究で、言語学の知見を取り入れながら、独自の方向性を見出していきたいと思っています。この種の研究は、言語に対する知識を蓄積するという意味で、大きな意義のある研究につながるのではないかと考えています。

博士論文では非常にマクロな視点で、あらゆる言語になりたつ普遍性という観点から研究を行ったのですが、特に最近興味があるのは、もう少しミクロな視点、例えば異なるジャンルの文章に対する文であったり、ネイティブと非ネイティブの書く文に対して、その差異を定量的に論じることができないかと考えているところです。